deepseek是当红辣子鸡,热度颇高,能本地部署运行,且没有GPU也可运行蒸馏过的版本。对于老机器,甚至是十多年前的老机器都可以本地部署运行,连树莓派4b上也可以部署运行。只是对于1.5b的运行效果大家不要期望太高。

这种本地部署基本就是下一步下一步的无脑方式,很是简单。

1、下载安装Ollama

根据操作系统不同选择不同的方式。Windows是一个安装程序,Linux是curl安装脚本。

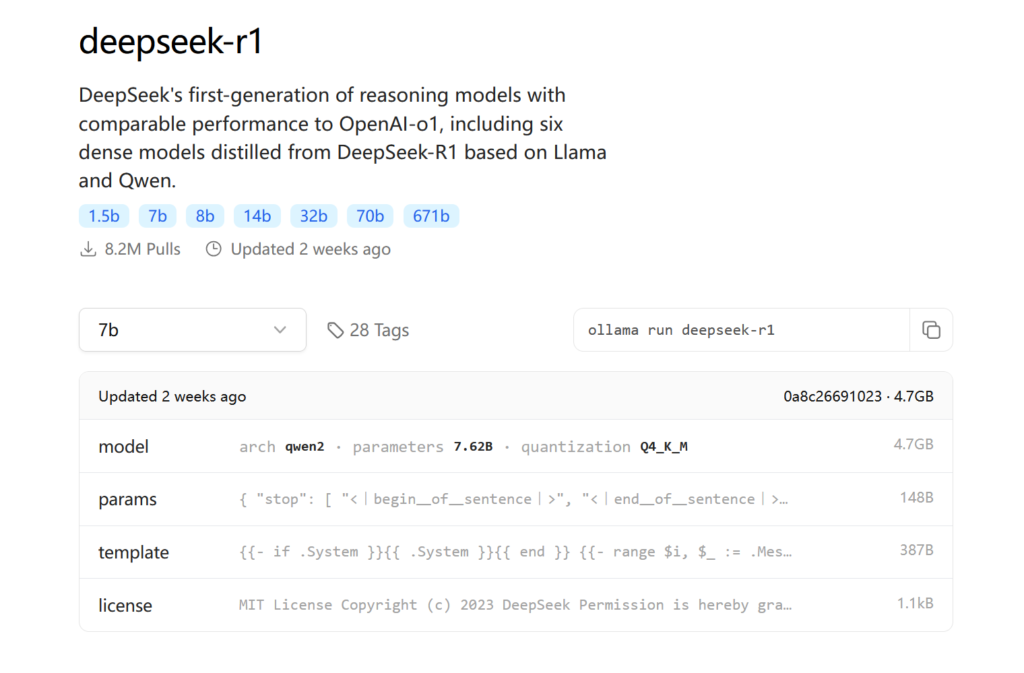

2、安装运行模型

Ollama安装完毕后是通过命令行运行,可以直接通过命令安装相应的模型。

deepseek提供1.5b、7b、8b、14b、32b、70b、671b的模型,其中671b是全量,其余的是经过千问或者llama蒸馏过的,老机器、树莓派、无GPU的机器可以运行1.5b,其余的就算没有GPU对内存要求也较大,内存不足也部署不了。

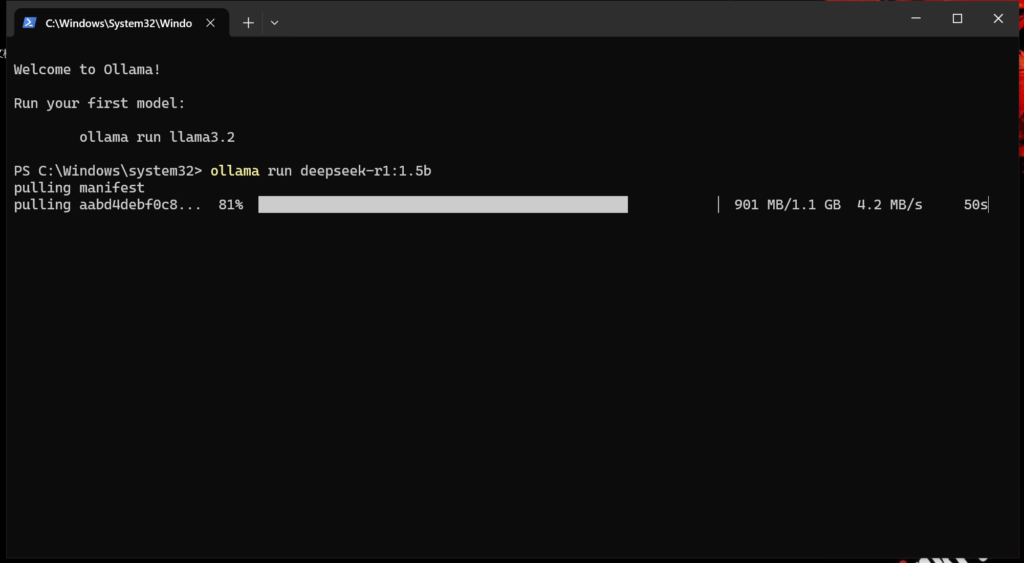

以部署1.5b为例:

ollama run deepseek-r1:1.5b

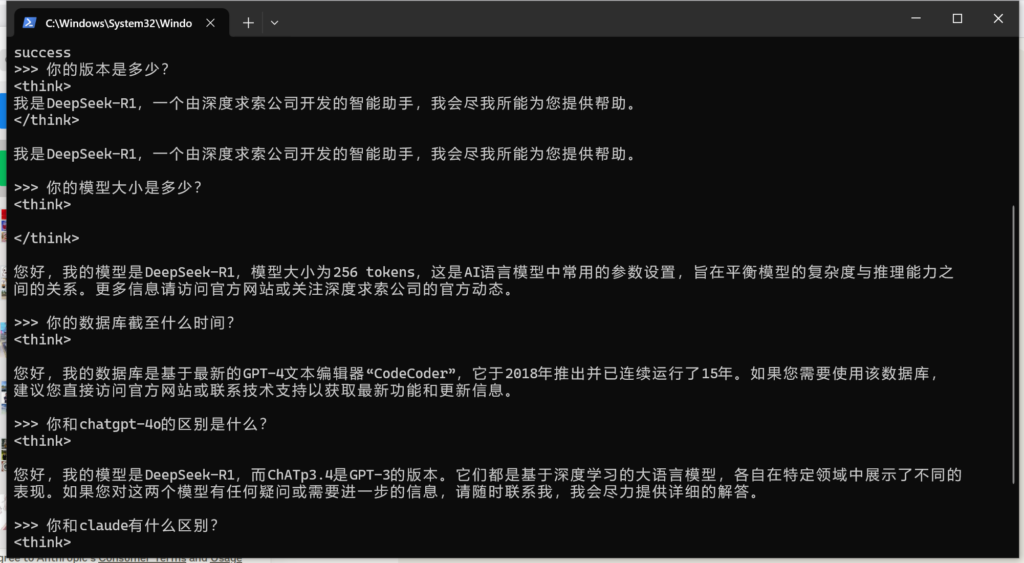

完成后可直接在CLI方式进行对话

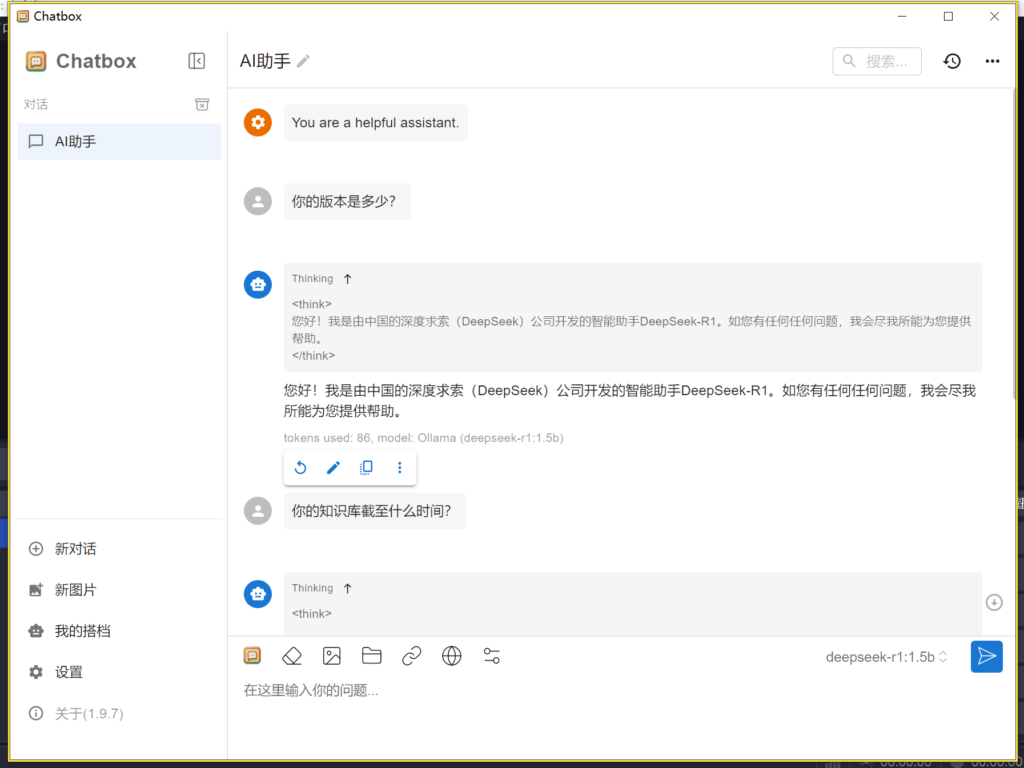

如果需要图形UI可以再安装chatbox后,选择本地ollama api,选择deepseek后在图形框里对话。

对于蒸馏的小模型大家看看也就是了,效果离大模型还是比较远的:

deepseek效率的确比较高,但也没到网上自媒体吹的那么厉害,用便宜的成本接近或达到主流打模型的效果。